Индексация сайта — то, без чего невозможно SEO-продвижение. Если поисковые роботы не проиндексировали страницы вашего ресурса, то они не попали в индекс, и не отображаются пользователям в поисковой выдаче.

Почему не индексируется сайт?

Бывают ситуации, когда вебмастер ведет работу над SEO-оптимизацией сайта: активно наполняет его контентом, наращивает ссылки, а количество страниц в поисковой выдаче Google или «Яндекс» не увеличивается. Или что еще хуже — в поиске нет ни одного документа с сайта. С чем это связано? Самые распространенные причины:

«Яндекс» и Google не знает о вашем сайте

Если это новый ресурс, и вы только недавно открыли его для поисковых роботов, то, возможно, они просто его еще не нашли. Но эту проблему легко решить, выполнив несколько простых манипуляций:

- Добавить сайт в «Яндекс.Вебмастер» и Google Webmasters.

- Направить поисковых роботов на страницы сайта.

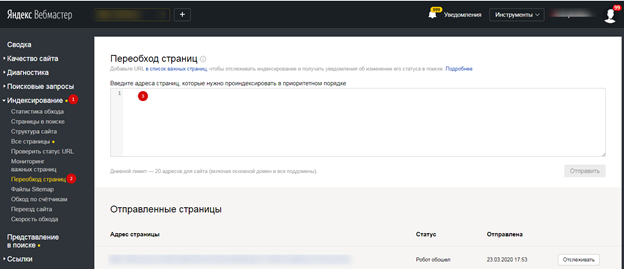

В «Яндекс.Вебмастер» («Индексирование» — «Переобход страниц»):

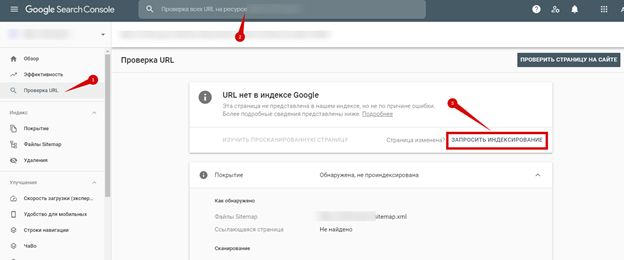

В Google Webmasters («Проверить URL» — Добавить адрес страницы — «Запросить Индексирование»):

Нужно будет немного подождать, пока робот обойдет страницы сайта. Как правило, на это уходит 1-2 часа (хотя может затянуться на несколько дней).

Сайт или страницы закрыты от индексации в файле robots.txt

Порой вебмастера, работая над сайтом, забывают открыть его для индексации. Но это легко исправить. Добавьте следующую команду в файл:

User-agent: *

Disallow:

Это означает, что ресурс открыт для всех поисковых роботов. Но не забывайте, что нужно закрыть дубли на сайте, ведь не все содержимое должно принимать участие в поиске. Поэтому уделите заполнению файла robots.txt достаточно времени.

Настройки приватности

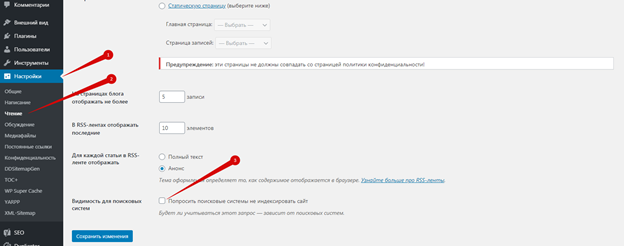

Если сайт управляется CMS WordPress, то по умолчанию в нем выставлены настройки приватности, которые запрещают индексацию поисковыми роботами. Авторизуйтесь в админке, перейдите в «Настройки — Чтение — Видимость для поисковых систем» и снимите галочку:

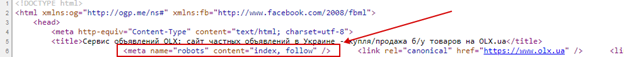

Сайт закрыт от поисковых роботов в мета-тегах

Запретить индексировать содержание страниц можно и с помощью мета-тега:

<meta name=«robots» content=«no index, nofollow»>

Как решить проблему:

- Посмотрите, нет ли такого тега на странице.

- Удалите код или добавьте другие мета-теги follow и index.

Ошибки сканирования

Проблемы с индексацией возникают и в том случае, если робот, обращаясь к ресурсу, не может просканировать его содержимое.

Проверьте все ли в порядке:

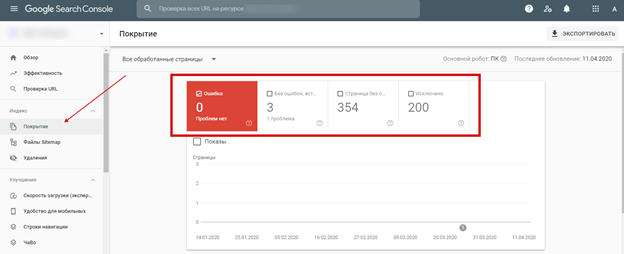

- Авторизуйтесь в Google Webmaster.

- Откройте «Сканирование» — «Ошибки сканирования»:

В идеале не должно быть никаких ошибок.

Сайт закрыт от роботов в .htaccess

В этом файле содержится правило 301 редиректа. Но помимо него, может быть прописана команда не индексировать сайт.

Чтобы проверить, выполните следующее:

- Найдите и откройте файл файл .htaccess на сервере.

- Проанализируйте содержимое кода.

Нестабильная работа сервера или хостинга

Выбирайте стабильный хостинг с хорошей репутацией. В противном случае, если роботы будут обращаться к сайту, он будет часто недоступен, а их попытки станут все реже. Через некоторое время они и вовсе откажутся заходить к вам на сайт.

Проблемы с индексацией AJAX/JavaScript

Поисковым роботам сложнее просканировать содержимое AJAX и JavaScript, чем HTML. Если вы допустите ошибки при оптимизации, то Google и «Яндекс» не проиндексируют определенные страницы или даже весь сайт.

Дубли контента внутри сайта

За дублирование контента поисковые системы наказывают санкциями, но это тоже одна из причин плохой индексации. К дублям может относиться одинаковый контент, открывающийся на разных страницах, мета-теги или даже страницы, если они доступны под двумя адресами (с www и без; http и https). Если не исправить проблему своевременно, то она негативно скажется на дальнейшем SEO-продвижении.

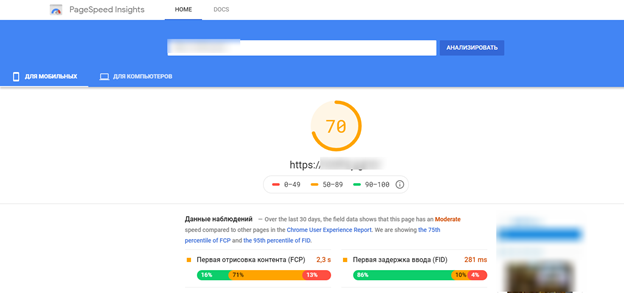

Плохая скорость загрузки

При плохой скорости загрузки ресурса, он может плохо индексироваться и потерять позиции, так как этот показатель относится к факторам ранжирования. Проверить насколько быстро загружается ваш сайт можно с помощью специального инструмента — Google Page Speed:

Поработайте над улучшением скорости загрузки сайта, учитывая рекомендации инструмента.

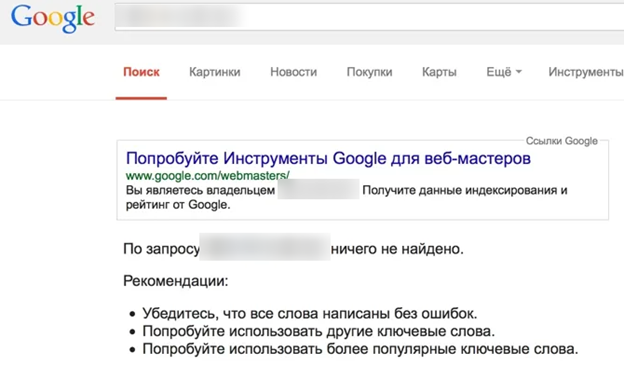

Домен с баном

Случается, что вебмастер выбирает и регистрирует созвучное имя для сайта, наполняет ресурс и ждет, когда он проиндексируется, но ничего не происходит. После анализа домена, выясняется, что домен ранее использовался и находится в бане поисковых систем.

Исправить такую ситуацию не просто. Придется написать в тех. поддержку «Яндекс», чтобы они пересмотрели ресурс или указали причину бана (если вы ее не знаете). Заниматься ли развитием сайта на этом домене — решать вам. Ориентируйтесь на то, что ответит вам техническая поддержка. Часто бывает проще начать все на новом домене.

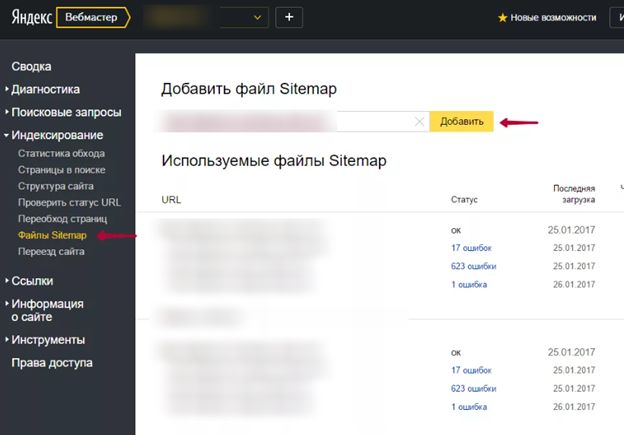

Отсутствует sitemap

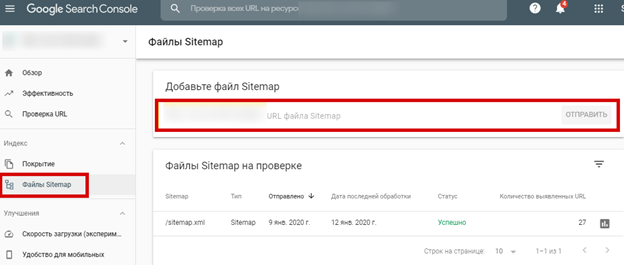

Не самая распространенная причина плохой индексации, но не стоит ее исключать. Создайте карту сайта и не забудьте добавить ее в сервисы для вебмастеров от Google и «Яндекс»:

В «Гугл вебмастер»:

Норма индексации в «Яндекс»

В среднем поисковая система «Яндекс» сканирует и добавляет в поисковую выдачу страницы несколько раз в месяц (2-4 раза). Однако авторитетные сайты с регулярным обновлением контента индексируются быстророботом и их материалы сразу попадают в поиск.

Нормы индексации в Google

Со скоростью индексации в Google ситуация обстоит несколько иначе. На нее может уйти от 1 дня до 2-х недель. Все зависит от показателей вашего ресурса. К примеру, сайты с постоянно обновляющимся контентом (новостники или форумы с высокой активностью) довольно часто посещают роботы. В результате попадание материалов в индекс — вопрос нескольких часов или дней.

Индексация среднестатистических сайтов с еженедельным обновлением контента осуществляется примерно за 2-4 дня. Новые сайты, которые только создали, могут в течение нескольких недель не попадать в индекс.

Если робот получает регулярные сигналы про обновление контента, он будет чаще заходить на такие сайты. Так, вы сможете увеличить скорость индексации новых материалов и получить дополнительный трафик.

Малополезные страницы для пользователей плохо индексируются и часто выпадают из индекса.

Как попросить поисковые системы временно не индексировать

Закрыть сайт от индексации можно несколькими способами:

- Специальные мета-теги robots noindex, nofollow. Используют, если нужно закрыть от индексации определенное содержимое на странице.

- Командой в файле robots.txt:

User-agent: *

Disallow: /

Если ваш сайт построен на движке WordPress, то достаточно зайти в «Настройки — Чтение» и отключить галочку напротив «Видимость для поисковых систем»:

Выводы

Если сайт долго не индексируется Google или «Яндексом», значит, на это есть определенные причины. Ваша задача — обнаружить и исправить проблему. Через некоторое время после проделанных работ, проверьте «зашли» ли ваши страницы в индекс.

Если вы сделали все правильно, то результат не заставит себя долго ждать. В противном случае, можете написать в техподдержку поисковой системы, чтобы специалисты указали на причину плохой индексации.

А как вы работаете над улучшением скорости индексации сайта? Поделитесь опытом в комментариях.

Если сайт не индексируется в яндекс и гугл. Необходимо устранить проблемы с индексацией.

спасибо за полезную информацию