Краулер (поисковый робот, бот, паук) — это программные модули поисковых систем, которые отвечают за поиск веб-сайтов их сканирование и добавление материалов в базу данных.

Поисковый паук без участия оператора посещает миллионы сайтов с гигабайтами текстов. Их принцип действия напоминает работу браузеров: на первом этапе оценивается содержимое документа, затем материал сохраняется в базе поисковика, после чего он переходит по линкам в другие разделы.

Какую работу выполняют роботы пауки поисковых машин

Малознакомые с принципом работы поисковых ботов вебмастера представляют их какими-то могущественными существами. Но, все гораздо проще. Каждый робот отвечает за выполнение своих функций.

Они не могут проникать как «шпионы» в запароленные разделы сайта, понимать работу фреймов, JavaScript или флеш-анимаций. Все зависит от того, какие функции в них были заложены разработчиками.

Скорость индексации и частота обходов сайта роботами во многом зависит от регулярности обновления контента и внешней ссылочной массы. Чтобы помочь боту проиндексировать все страницы, позаботьтесь о создании карт сайта в двух форматах .html и .xml.

Поисковая выдача формируется в 3 этапа:

- Сканирование — поисковые боты собирают содержимое сайтов (тексты, фото и видео).

- Индексация — робот вносит в базу данных собранную информацию и присваивает каждому документу определенный индекс. Материалы могут несколько дней находиться в быстровыдаче и получать трафик.

- Выдача результатов — каждая страница занимает определенную позицию по результатам ранжирования, заложенным в алгоритмах поисковых систем.

Специалисты Google и «Яндекс» часто вносят коррективы в работу поисковых роботов, например, ограничивают объем сканируемого текста или глубину проникновение паука внутрь сайта. Вебмастерам приходится адаптироваться под изменения при SEO-продвижении: выбирать оптимальные размеры текстов, ориентируясь на конкурентов в ТОП-10 выдаче, учитывать вложенность материалов, производить перелинковку материалов и так далее.

У каждой поисковой системы, будь то Google или «Яндекс», есть свои «пауки», отвечающие за разные функции. Их количество отличается, но задачи практически идентичные.

Как управлять поисковыми ботами?

Часто владельцы сайтов закрывают доступ некоторым поисковым роботам к определенному содержимому сайта, которое не должно принимать участие в поиске. Все команды паукам прописываются в специальном файле robots.txt.

Документ предоставляет краулерам список документов, которые нельзя индексировать (это может быть технические разделы сайта или личные данные пользователей). Ознакомившись с правилами, робот уходит с сайта или переходит на разрешенные для сканирования страницы.

Что указывать в robots.txt:

- Закрывать/открывать для индексации фрагменты контента или разделы сайта.

- Интервалы между запросами поисковых ботов.

Команды могут быть общими для всех роботов или отдельные для Yandex, Googlebot, Mail.Ru. Подробнее о работе с robots.txt читайте здесь.

Как узнать, что поисковый робот посещает сайт?

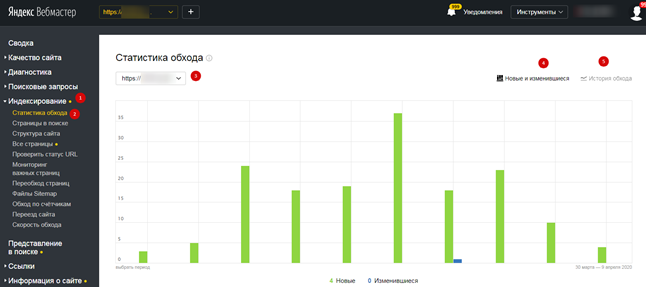

Существует несколько способов, позволяющих определить, как часто на ваш сайт заходят краулеры. Проще всего это отследить робота от «Яндекса». Для этого авторизуйтесь в сервисе «Яндекс.Вебмастер», откройте страницу «Индексирование» и «Статистика обхода»:

В этом разделе вы узнаете, какие страницы обошел робот, как часто обращался к вашему сайту («История обхода») и ошибки, случившиеся по причине перебоев со стороны сервера или неправильного содержимого документов.

Чтобы получить подробную информацию по конкретному разделу, найдите его в списке, где указан URL-сайта.

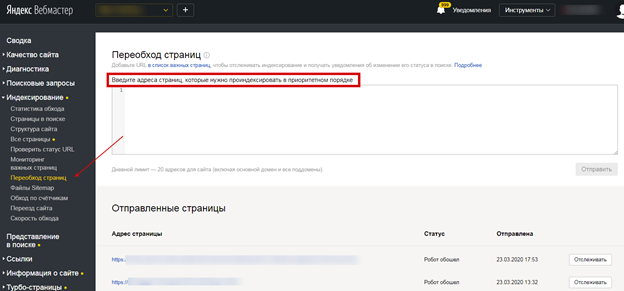

Рассказать поисковому роботу и направить на конкретную страницу можно с помощью инструмента «Переобход страниц». Добавьте урл-адреса в соответствующее поле:

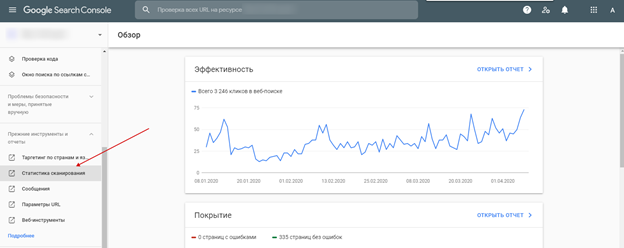

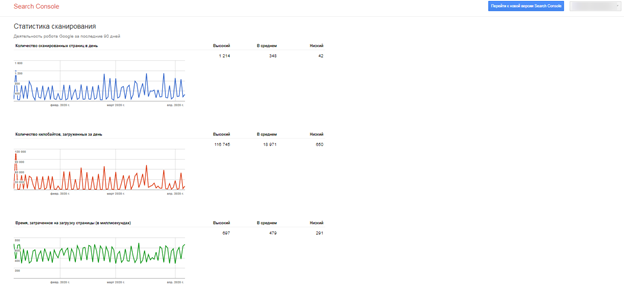

Точно также успешно можно отследить и посещение поискового робота Google. Для этого авторизуйтесь в Google Analytics.

Появятся данные про обход страниц роботом:

Выводы

Краулеры нужны не только поисковым системам для индексирования сайтов и добавления документов в базу данных, но и для SEO-специалистов, чтобы анализировать ресурсы, исправлять недочеты и успешно продвигать их в поиске.

Вебмастера будут всегда пытаться разгадать алгоритмы работы поисковых роботов, которые постоянно совершенствуются. Работа над качеством сайта — долгий и тернистый путь, направленный на долгосрочный результат.

А у вас не было проблем с индексацией сайта? Отслеживаете ли вы посещение сайта поисковыми роботами? Поделитесь свои опытом в комментариях.